Transformer l’éthique en levier de confiance

Dans les directions générales, l’intelligence artificielle inspire autant qu’elle inquiète.

D’un côté, un formidable potentiel de transformation.

De l’autre, la crainte des risques éthiques, réglementaires et réputationnels.

Pendant longtemps, l’éthique a été perçue comme un frein : une case à cocher, une contrainte administrative.

Mais cette vision appartient au passé.

En 2025, avec l’AI Act européen et la montée des attentes sociétales, l’éthique devient un avantage compétitif.

C’est elle qui protège la marque, rassure les collaborateurs et fidélise les clients.

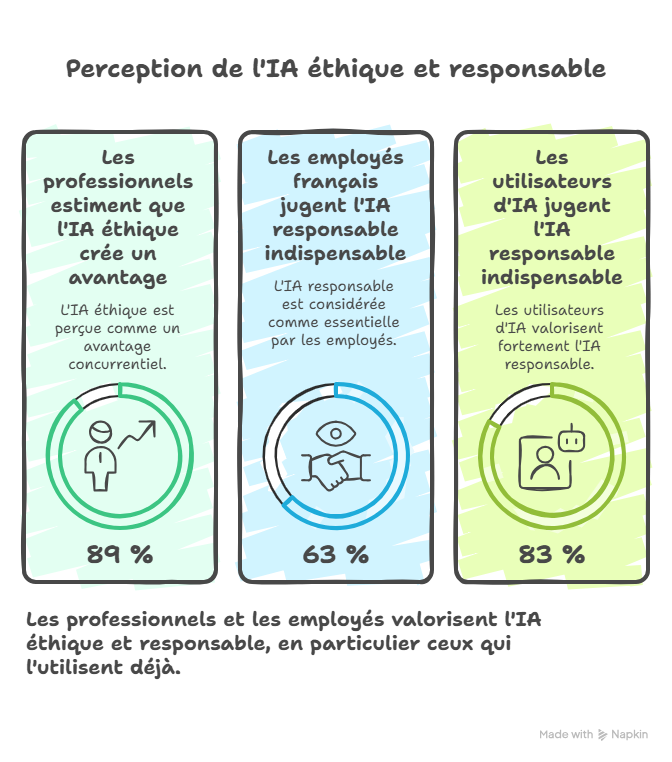

📊 Les chiffres sont clairs :

89 % des professionnels estiment qu’une IA éthique peut créer un avantage concurrentiel.

63 % des salariés français jugent une IA responsable indispensable.

Et ce taux grimpe à 83 % chez ceux qui l’utilisent déjà.

Loin de ralentir l’innovation, l’éthique l’oriente dans la bonne direction.

L’AI Act européen change la donne

Entré en vigueur le 1er août 2024, l’AI Act établit un cadre inédit pour encadrer le développement, la commercialisation et l’usage de l’intelligence artificielle en Europe.

Il repose sur un principe de gradation des risques :

| Niveau de risque | Exemples | Exigences |

| 🚫 Inacceptable | notation sociale, surveillance biométrique, détection d’émotions au travail | Interdiction totale |

| ⚠️ Élevé | recrutement, scoring RH, santé, justice | Conformité, documentation, audits |

| ℹ️ Spécifique | IA générative, chatbots | Transparence obligatoire |

| ✅ Faible | outils courants d’assistance | Principe de responsabilité |

📅 Échéances clés :

Août 2025 : transparence obligatoire pour les IA génératives.

Août 2026 : conformité complète pour les systèmes à haut risque.

Les sanctions peuvent atteindre 4 % du chiffre d’affaires mondial (ou 20 M€).

Mais le vrai risque, c’est la perte de confiance — celle des collaborateurs, des clients et des partenaires.

Les 5 principes d’une IA responsable

1️⃣Transparence et explicabilité : sortir de la boîte noire

Les systèmes d’IA ne doivent plus être des mystères.

Quand un algorithme prend une décision, il doit pouvoir expliquer pourquoi et comment.

💬 Exemple :

Dire à un client “Nous vous recommandons ce produit car il correspond à votre profil d’achat” inspire bien plus de confiance qu’une suggestion automatique opaque.

Ce que cela change concrètement

Pour les clients : +34 % de confiance quand l’usage de leurs données est transparent.

Pour les collaborateurs : meilleure adoption et moins de peur de “l’IA qui remplace”.

Pour les régulateurs : obligation de documenter, tracer et auditer chaque système IA.

Comment faire

Documenter chaque IA (données, finalité, logique, limites).

Intégrer des explications compréhensibles dans les interfaces.

Former les équipes à comprendre et expliquer les décisions IA.

2️⃣ Équité et réduction des biais : garantir un traitement juste

Un algorithme n’est jamais neutre par nature : il apprend à partir de données humaines, donc imparfaites.

Les biais apparaissent quand les données reflètent des inégalités existantes — et risquent de les amplifier.

🎯 Exemple :

Un algorithme RH entraîné sur des données internes majoritairement masculines tendra à reproduire cette disparité dans ses recommandations.

Conséquences

Risques juridiques (discrimination).

Atteinte à la réputation.

Perte de performance : un biais ferme des portes à des talents ou clients.

Les bonnes pratiques

Auditer les jeux de données avant tout déploiement.

Tester la performance sur différents groupes (genre, âge, origine).

Rééquilibrer les données pour garantir une représentation équitable.

Superviser humainement les résultats et les décisions sensibles.

3️⃣ Protection des données : sécuriser la confiance

93 % des collaborateurs introduisent des données sensibles dans des IA non autorisées.

Le risque ? Des fuites, des sanctions, une perte de crédibilité.

Les fondations d’une IA sécurisée

Minimiser la collecte : ne garder que le nécessaire.

Anonymiser et chiffrer les données.

Associer le DPO dès la conception du projet IA.

Informer clairement sur les données collectées, leur usage, leur durée de conservation.

💬 Un cadre clair ne freine pas : il crée la confiance, interne comme externe.

4️⃣ Responsabilité et supervision humaine : garder le contrôle

L’IA ne décide pas seule.

Elle recommande, propose, accélère — mais l’humain reste responsable.

En pratique

Comité de gouvernance IA : direction, métiers, IT, RH, juridique, DPO.

Validation humaine obligatoire sur les décisions critiques (recrutement, crédit, santé).

Traçabilité complète de chaque recommandation IA.

Mécanisme de contestation accessible à toute personne concernée.

L’IA la plus performante reste celle que l’on peut contrôler, expliquer et ajuster.

5️⃣ Impact sociétal et environnemental : construire une IA durable

L’éthique ne s’arrête pas à la conformité : elle touche aussi à l’humain et à la planète.

44 % des entreprises françaises font de l’éthique un moteur de leur stratégie IA.

8 salariés sur 10 estiment qu’une IA responsable doit respecter le bien-être humain.

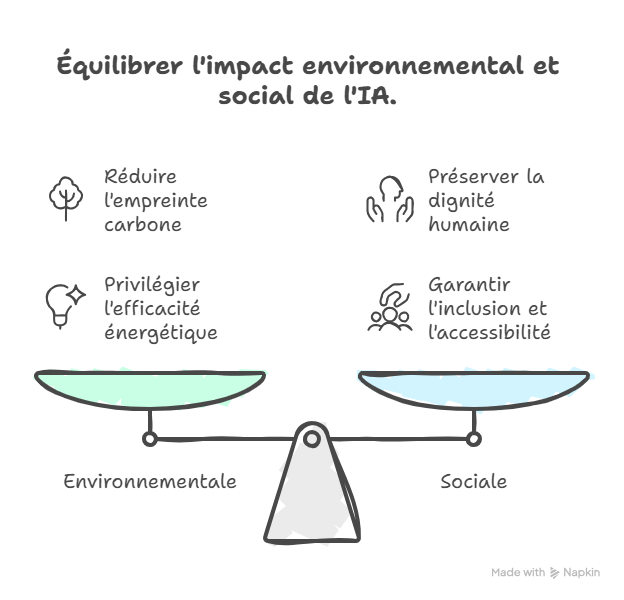

Deux dimensions clés

🌍 Environnementale : réduire l’empreinte carbone des modèles IA, limiter les traitements inutiles, privilégier l’efficacité énergétique.

🤝 Sociale : préserver la dignité humaine, éviter la surveillance excessive, garantir l’inclusion et l’accessibilité.

Chaque déploiement IA doit être évalué sur ces impacts — positifs comme négatifs — et communiqué en toute transparence.

Transformer l’éthique en avantage concurrentiel

Ce que montre l’expérience

+34 % de confiance client grâce à la transparence.

+15 % de satisfaction client en 12 mois avec une IA éthique.

+23 % de productivité dans les équipes engagées.

Les entreprises pionnières — Macif, BNP Paribas, Orange, L’Oréal — ont toutes structuré leur gouvernance IA autour de la responsabilité, de la transparence et de la formation.

Même les PME innovent : Eziom a créé EZIA, une IA française pensée pour les TPE, fondée sur la souveraineté et la transparence.

Comment Transition fait de l’éthique un levier stratégique

Chez Transition, nous aidons les dirigeants à intégrer l’éthique comme moteur de performance.

Notre méthode repose sur cinq étapes :

1️⃣ Diagnostic de maturité éthique : évaluer vos usages IA, y compris le Shadow AI.

2️⃣ Co-construction d’une charte IA : définir vos principes et lignes rouges.

3️⃣ Mise en conformité progressive : prioriser les actions critiques selon l’AI Act.

4️⃣ Formation et acculturation : former vos équipes à la pratique d’une IA responsable.

5️⃣ Mesure et valorisation : documenter vos engagements et les transformer en atout commercial.

Parce qu’une IA éthique n’est pas une contrainte. C’est un accélérateur de confiance.

Conclusion : la vraie performance est celle qu’on peut expliquer

Dans un monde où l’IA s’impose partout, la responsabilité devient le meilleur avantage concurrentiel.

Les entreprises qui prennent l’éthique au sérieux ne se contentent pas de se protéger : elles se différencient.

Transparence, équité, protection, supervision, impact :

ces cinq principes ne sont pas des contraintes, mais les fondations d’une performance durable.

Chez Transition, nous croyons qu’une IA responsable, c’est une IA utile, humaine et maîtrisée.

Parce que la vraie performance, c’est celle qu’on peut expliquer.

Celle qui inspire confiance.

Celle qui dure.